▣ 의사결정 트리(decision tree), 정보 이득 (information gain), 엔트로피 (entropy)

2017년 71번

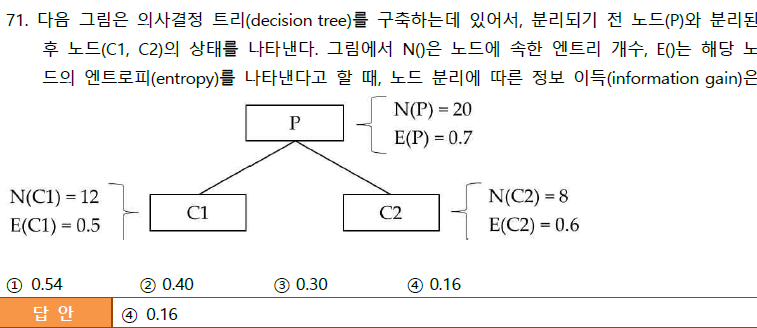

엔트로피(entropy)는 정보의 불확실함의 정도를 나타내는 양(정보에 대한 기대 값)을 의미함

정보 이득(information gain)은 데이터를 분할하기 전과 후의 변화를 의미함

즉, 정보의 불확실성이 얼마나 해소되었는지를 측정하는 것임

상위노드 P 의 엔트로피 E(P) = 0.7

하위노드 C1 의 엔트로피 E(C1) = 0.5

하위노드 C2 의 엔트로피 E(C2) 0.6

정보 이득 (information = 0.7 - ( 12/20 * 0.5 + 8/20*0.6 )

= 0.7 - ( 0.3 + 0.24 )

= 0.16

'데이터베이스' 카테고리의 다른 글

| 구글(Google)의 PageRank 알고리즘 (0) | 2021.09.10 |

|---|---|

| 분산 데이터베이스_분할(fragmentation) 수직, 수평, 혼합, 분산데이터 베이스 크기, 세미조인, 단편화 (0) | 2021.09.10 |

| 권한 부여(GRANT, REVOKE, WITH GRANT OPTION) (0) | 2021.09.10 |

| 조인 선택률(Join selectivity), 조인 선택도, 조인 카디널리티(cardinality) (0) | 2021.09.10 |

| 유클리드(Euclidean) , 맨하탄(Manhattan) 거리측정법 (0) | 2021.09.10 |